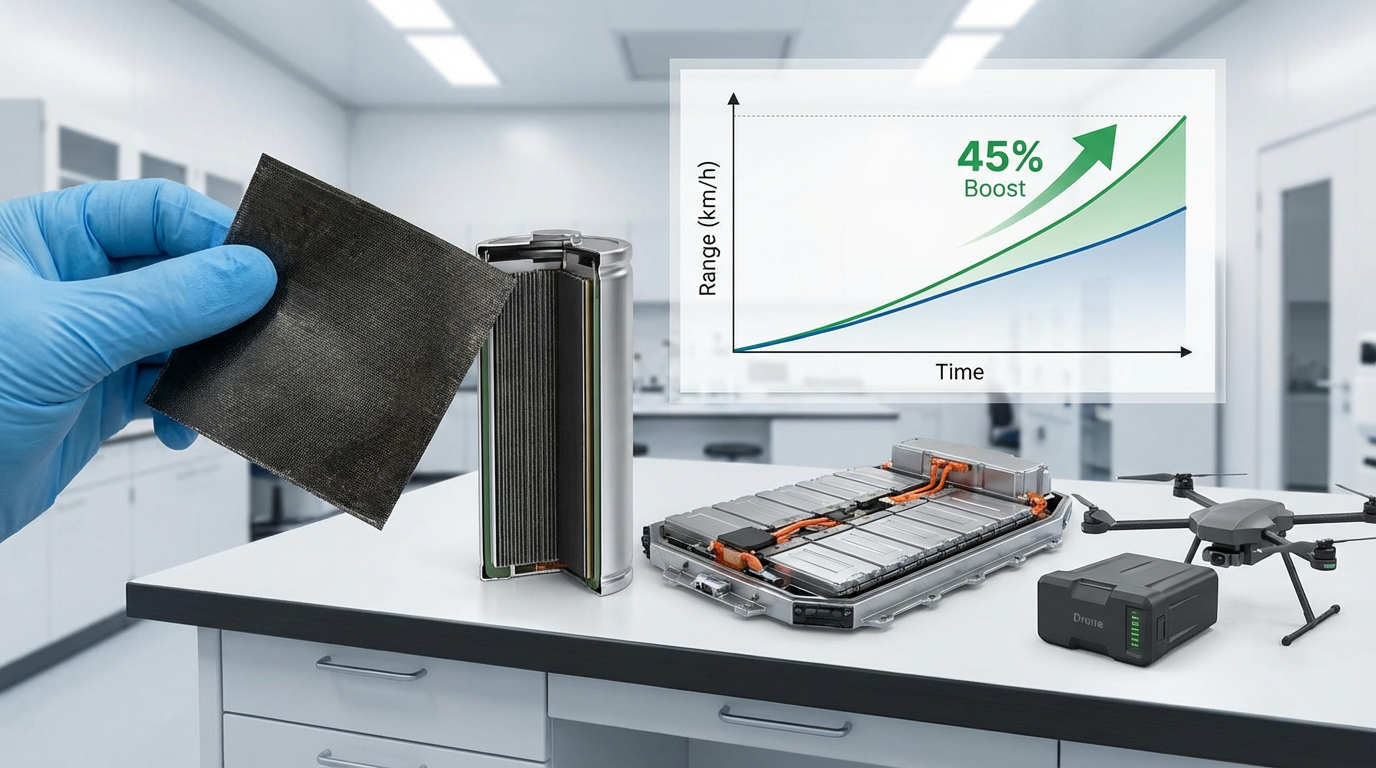

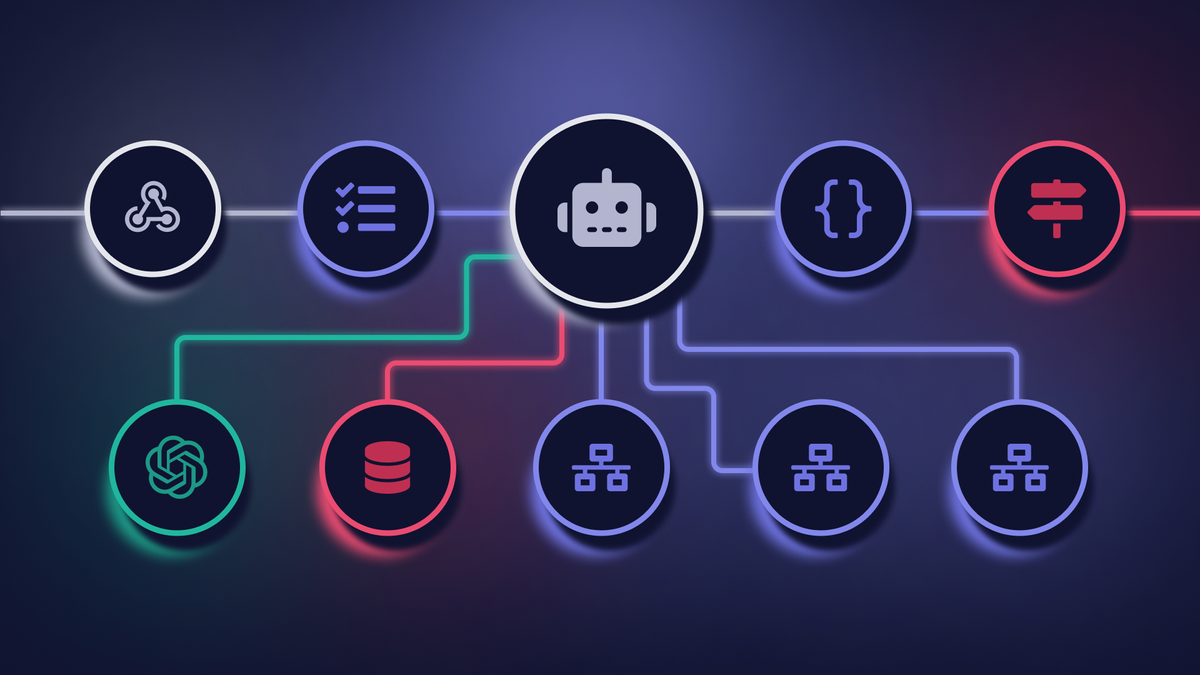

Архитектура Mixture-of-Experts (MoE) представляет собой перспективное решение для повышения эффективности больших языковых моделей (LLM), таких как GPT-4, которая в 2023 году была оценена в 100 долларов за использование. Это новшество позволяет значительно сократить вычислительные затраты, сохраняя при этом высокую производительность.

Преимущество MoE заключается в том, что она активирует лишь часть своих компонентов для выполнения задач, что делает процесс более экономичным. Это открытие уже привлекло внимание крупных игроков на рынке, таких как Google, который начал разработку MoE еще в 2017 году. В настоящее время система активно используется в таких моделях, как Mixtral, Mistral 3, DeepSeek и DBRX.

С появлением новых решений, таких как Kimi K2 Thinking и Qwen, конкуренция в области разработки языковых моделей становится все более напряженной. Внедрение MoE может изменить правила игры на рынке, предоставляя более эффективные инструменты для разработчиков и пользователей.

В условиях растущих затрат на вычисления, внедрение Mixture-of-Experts может стать решающим фактором для компаний, стремящихся сохранить конкурентоспособность и оптимизировать свои расходы на технологии. Это может привести к новому витку инноваций среди конкурентов, что в конечном итоге повлияет на весь рынок LLM.

Meta* (Instagram*, Facebook*) и другие признанные экстремистскими организации/ресурсы запрещены в РФ.

Упоминания иностранных агентов сопровождаются маркировкой по закону.

Информационный материал. 18+.